Nachdem in der letzten Zeit die technischen Artikel wieder überwiegt haben, ist es jetzt mal wieder Zeit für eine weitere Episode des PLM Talks. Ich habe weder Kosten noch Mühe gescheut, um einen weiteren hochkarätigen Gesprächspartner zu gewinnen. Das heutige Interview führe ich mit Markus Ripping, beim Biotech- und Laborzulieferer Sartorius global verantwortlich für das Thema PLM. Ich wünsche dem geneigten Besucher dieses Blogs viel Spaß beim Lesen dieses Interviews.

Herzlich Willkommen auf meiner virtuellen Blogcouch, Herr Ripping. Machen Sie es sich bitte recht bequem. Viele Leser dieses Artikels werden sie aus ihren zahlreichen PLM-Projekten in mittlerweile über 15 Jahren kennen. Können Sie trotzdem bitte ein paar Worte zu ihrer Person und ihren bisherigen beruflichen Stationen verlieren?

Markus Ripping: Gerne. Zu meiner Person: Baujahr 77, verheiratet, ein Sohn. Gelernter Dipl-Ing. Verkehrswesen, Luft- und Raumfahrt. Ich hatte am Anfang meiner Karriere die Chance, in einen militärisch beeinflussten Industriebetrieb zu schnuppern, was bei mir praktisch unmittelbar den Reflex ausgelöst hat, in ein Umfeld höherer Dynamik zugehen und erstmal nicht in der Industrie zu arbeiten. Ich hab mich dann rund 15 Jahre in der technologie-lastigen Unternehmensberatung rumgetrieben. In der Zeit habe ich das Spektrum von kleiner, lokaler Nischen-Beratung bis zum internationalen „Monster“ für mich ausprobiert.

Markus Ripping: Gerne. Zu meiner Person: Baujahr 77, verheiratet, ein Sohn. Gelernter Dipl-Ing. Verkehrswesen, Luft- und Raumfahrt. Ich hatte am Anfang meiner Karriere die Chance, in einen militärisch beeinflussten Industriebetrieb zu schnuppern, was bei mir praktisch unmittelbar den Reflex ausgelöst hat, in ein Umfeld höherer Dynamik zugehen und erstmal nicht in der Industrie zu arbeiten. Ich hab mich dann rund 15 Jahre in der technologie-lastigen Unternehmensberatung rumgetrieben. In der Zeit habe ich das Spektrum von kleiner, lokaler Nischen-Beratung bis zum internationalen „Monster“ für mich ausprobiert.

PLM und Systems Engineering wird bei Raumfahrern mit der Muttermilch aufgesogen. Eine Konzentration auf das Thema war daher naheliegend. Anfangs waren das für mich Visualisierungs– und Kollaborationsthemen eher konzeptioneller Natur. Immer mit einem Fokus, das Business zu verstehen und Mediator Richtung IT zu sein. Aus den Extended Enterprise Fragestellungen ist dann irgendwann der Themenkomplex Business Process Outsourcing im PLM-Umfeld entstanden. Da ging es deutlich mehr um operatives Tagesgeschäft und wie man Konstruktions- und Qualitätssicherungsmaßnahmen im Design-Prozess sinnvoll nach offshore verlagert. Die letzten Jahre in der Beratung waren geprägt von eher strategischer Beratung und einem Fokus auf die Wechselwirkungen von PLM in Merger & Acquisition bzw. Divestment Situationen.

Als mein Sohn zur Schule kam hab ich mein Leben aus dem Koffer an den Nagel gehängt und bin in die Industrie und gleichzeitig meine alte Heimat gewechselt. Hier habe ich die Chance – dank dynamischen Wachstums in der Biotech-Branche – eine Reise in die PLM-Zukunft zu begleiten und dem Unternehmen mit meinem kleinen Beitrag zu helfen, den Sprung vom Familienunternehmen in die Global-Enterprise-Welt zu schaffen.

In ihren beruflichen Stationen in verschiedenen Unternehmensberatungen konnten Sie einen vielfältigen Einblick in das Thema PLM gewinnen. Was unterscheidet aus ihrer persönlichen Sicht heraus ein PLM Projekt im Jahr 2018 von einem PLM Projekt im Jahr 2008. Oder anders gefragt, was ist der Erkenntnisgewinn der letzten 10 Jahre PLM?

Da gibt es vielfältige Antwortmöglichkeiten. „Standards“ wäre eine. Vor 10 Jahren waren in PLM-Umgebungen vieles noch selbstgebaut. Aus der Not heraus geboren. Heute haben wir akzeptiert, dass wir keine monolithischen Systeme bauen müssen, unter anderem auch dank offener Standards und einfach erreich- und implementierbarer Interfaces. Themen wie cpo sind wichtig und intensiv voranzutreiben.

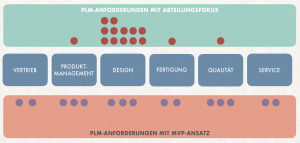

Eine andere Perspektive ist die Anwendung von PLM im Unternehmen. Vor 10 Jahren waren PLM-Projekte ehrlicherweise oft noch PDM-Projekte. PLM war die Spielwiese der Produktentwicklung. Das hat sich geändert. Die ersten waren die Manufacturing-Leute, die die Mehrwerte einer harmonisierten Landschaft neben ERP verstanden haben. Heute unterhalten wir uns mit Marketing und Service und nähern uns einer echten End2End-Abdeckung. Damit werden wir endlich dem „Lifecycle“ in PLM gerechter.

Wenn Sie heute auf ihre erste berufliche Station zurückblicken und heute in ihrem Team Nachwuchskräfte sehen, was können sie jungen Ingenieure und Ingenieurinnen raten, die sich für dieses Thema interessieren. Wir sind beide aus der Generation, die noch die klassischen Diplomstudiengänge absolviert haben. Sind die jungen Kollegen und Kolleginnen heute besser oder „nur“ anders vorbereitet auf die Herausforderungen des PLMigen Berufslebens?

Ich hab mich damals eigentlich schon nicht schlecht vorbereitet gefühlt. Aber in der Tat hat sich seitdem vieles verändert. Mir hat man noch Wasserfall beigebracht als wäre es die einzige Möglichkeit, Software-Projekte abzuwickeln. Mein Ratschlag an junge Leute: Über den Tellerrand schauen. Der Ingenieur darf heute kein reiner Technik-Experte sein.

In meinen Teams gibt es immer auch Spezialisten u.a. für Change Management. Man muss die Leute mit ihren Ängsten und Sorgen abholen. Das haben wir früher vernachlässigt. Eine weitere Erkenntnis: Gute Dinge tun reicht nicht. Man muss sie auch verkaufen können. Daher muss heute mehr Wert auch auf das interne Marketing von PLM-Aktivitäten gelegt werden. Das bedarf eines ganz anderen Skillsets als an den technischen Lösungen zu arbeiten. Diese Interdisziplinarität ist einer der Schlüssel zum Erfolg. Daher helfen heute eher Generalisten als Spezialisten.

Sie blicken auf eine langjährige Erfahrung als PLM-Experte und Berater zurück. Ich möchte zuerst nach den positiven Dingen fragen: Was hat sich Ihrer Meinung nach verbessert in den PLM Projekten über diese Zeit?

Heute verfügbare Technologie und die Fähigkeiten, Komplexität zu managen machen aktuelle PLM-Projekte mit höherer Wahrscheinlichkeit erfolgreich, als das am Anfang meiner Karriere der Fall war. Da ist deutlich häufiger auch Geld in den Sand gesetzt worden. Außerdem hat sich die Erkenntnis deutlich breiter durchgesetzt, dass PLM nicht nur ein System ist, sondern eine Strategie des Unternehmens sein muss und viel mehr von Prozessen als von IT-Tools lebt.

Und wo stehen wir immer noch vor den gleichen Problemen wie vor 15 Jahren?

PLM verkauft sich auf der Management-Ebene weiterhin nicht gut. Das Thema ist abstrakt, für Manager ohne technischen Hintergrund schwer greifbar und es fällt uns auch heute noch schwer, gute Business Cases aufzustellen. Die technologische Komponente ist eher ein Enabler für Andere als eine sich selbst tragende Geschichte. Wenn Sie sich ein optimales PLM Projekten backen könnten, welche Zutaten sind unabdingbar für den Erfolg des Projektes? Was sind die Randbedingungen und Voraussetzungen, ohne die kein PLM Projekt zu den gewünschten Ergebnissen führt?

- Management-Buy-In. Wenn es kein Commitment der Entscheider gibt, es wirklich durchzuziehen, braucht man gar nicht erst anfangen.

- Begehrlichkeit wecken. Die Menschen auf der Arbeitsebene müssen die Lösungen wollen. Ein klassisches Change Management Thema.

- Descoping. Die eierlegende Wollmilchsau braucht niemand und erreicht auch niemand. Iterativ oder besser noch agil vorgehen und eine kleine Baustelle nach der anderen integrieren. Dabei das große Ganze und die Zukunftsvision nicht vergessen.

Blicken wir einmal auch ein wenig in der Zukunft und versetzen uns mal in das Jahr 2028. Was denken Sie, was wird dann aus diesem PLM geworden sein. Ist das dann ein gelöstes Problem, das wenig Überraschungen mehr bietet? Oder welche Herausforderungen werden wir dann lösen müssen?

Sicher wird PLM kein final gelöstes Problem sein. In den letzten Jahren sind immer mal wieder Dinge in PLM rein- und wieder rausdefiniert worden. Das wird auch in Zukunft so gehen. Insofern ist das „Problem“ PLM nicht statisch beschrieben. Eine große Herausforderung, die ich sehe ist das Thema Definition von Produktdaten.

Heute machen wir PLM oft im Kontext diskreter Fertigung. Wie sieht das ganze aus, wenn das Produkt nur noch eine Dienstleistung ist? Wie gehen wir mit immer mehr Prozessdaten um? Was machen wir mit den Daten eines Asset Network? Und weitere neue Business-Modelle stehen in den Startlöchern, die wir heute nicht verstehen. Das iPhone ist 10 Jahre alt. Die Veränderung der letzten 10 Jahre hätte doch so kaum jemand vorhergesehen.

Abseits inhaltlicher Fragestellungen sehe ich einen gefährlichen Trend, dem Kind neue Namen umzuhängen, um PLM sexy zu machen. Das klappt meist leider nicht, weil es nur nicht erfüllbare Erwartungshaltungen schürt. Es wird neue Herausforderungen geben. Wir werden Sie mit PLM lösen. Ob wir es dann noch PLM nennen – ich hoffe schon!

Eine letzte Frage, die den Blick in Richtung der Softwareunterstützung richtet. Was wünschen Sie sich konkret von den PLM-Systemhäusern und auch den Dienstleistern? Wo können und müssen diese ihren Beitrag leisten, PLM zukunftsfähig zu machen?

Wie ich oben schon erwähnte: Offene Standards. Kaum jemand kauft sich eine fertige Suite und ersetzt in einem Schlag seine ganze Produktentstehungslandschaft. Darüber hinaus wünsche ich mir eine andere Dimension der Modularität. Ich polarisiere etwas: Heutige Systeme wirken wie funktionsüberfrachtete Monster. Man steckt mehr Geld hinein, vorhandene Funktionalität vor experimentierfreudigen Anwendern zu verstecken, als nützliche Funktionen bereitzustellen. Ich möchte nicht One-Size-Fits-All. Ich will einen Maßanzug. Aber bitte ohne stundenlang beim Schneider stehen zu müssen.

Vielen Dank für dieses Gespräch und weiterhin viel Erfolg bei Ihren Projekten.